快速使用指南:在 Glows.ai 上運行 LLAMA3.1

LLaMA 是由全球領先的 AI 研究機構 Meta 開發的自然語言處理(NLP)模型。憑藉可擴展的架構,模型規模從 70 億到 650 億參數不等,LLaMA 在多語言文本生成、對話式 AI、進階語言推理等任務中表現卓越,為企業、研究人員與開發者開啟了無限可能。

如今,透過社群推動與平台整合,運行 LLaMA 所需的完整環境已經觸手可及,包括預訓練模型檔案、運算資源與操作便利的工具。只需幾個步驟,就能完成環境設置、存取 WebUI,並全面發揮這款頂尖生成式 AI 模型的強大效能。

操作步驟說明

步驟 1:登入 Glows.ai 並啟動環境

-

註冊與登入

前往 Glows.ai,完成註冊流程並登入帳戶。 -

啟動環境

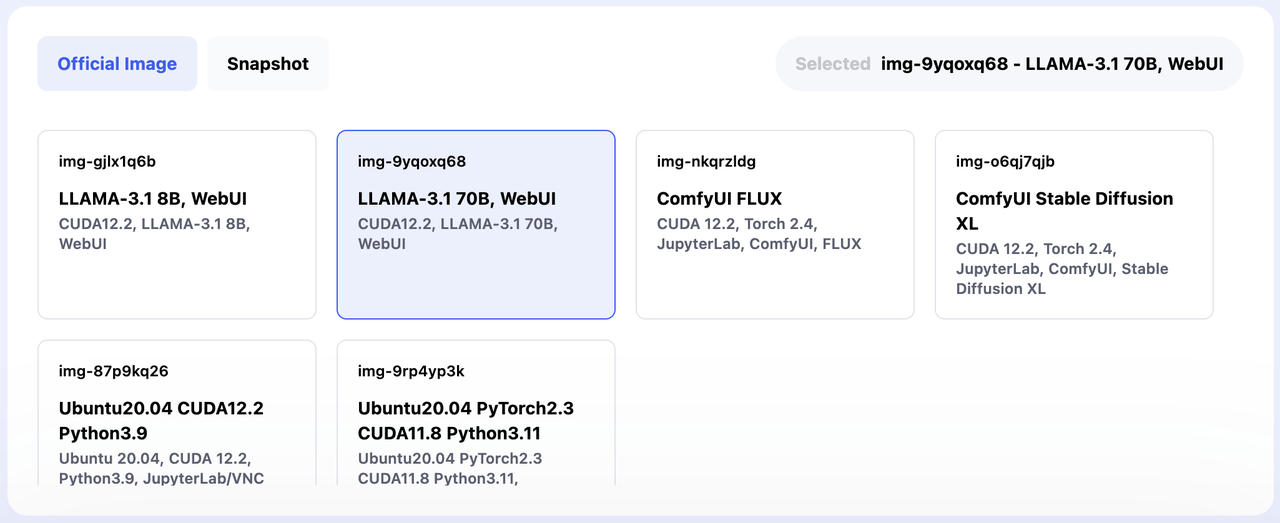

在儀表板中找到 LLAMA 的任務模板。只需點擊一次,系統便會自動幫你配置所有必要的資源與相依套件。

注意:Glows.ai 提供兩種 Llama 3.1 配置版本:- 8B:適合於一般消費級 GPU 設備(如個人電腦用顯示卡)優化,適合高效部署與開發。

- 70B:設計用於大規模 AI 原生應用。若要使用 70B 版本,需至少配備 2 單位 NVIDIA GeForce RTX 4090 GPU。

步驟 2:連線並使用 Llama 3.1

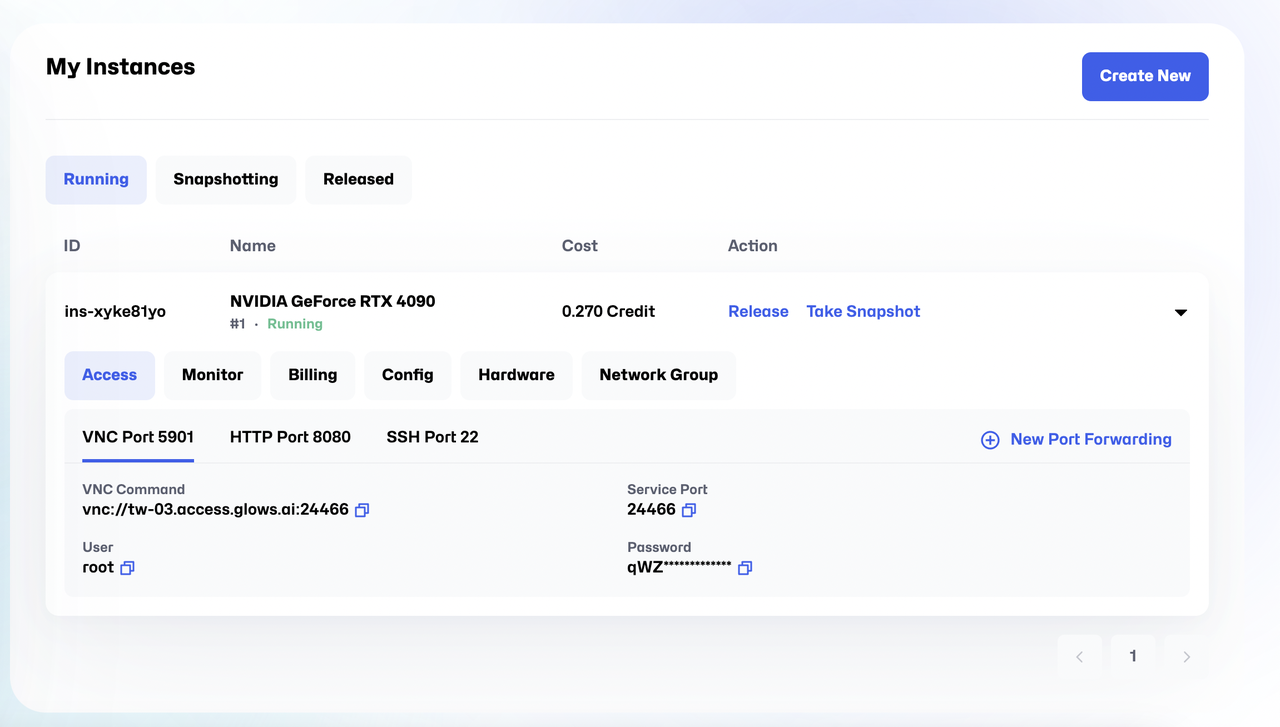

- VNC(Port 5901)

- 在

My Instances>Access>VNC Port中可以找到 VNC 連線指令與其他必要資訊。 - 詳細教學可參考:如何使用 VNC 連線到 Glows.ai 的計算資源。

- HTTP WebUI(Port 8080)

- 開啟網址連結:

https://tw-03.access.glows.ai:24527?token=iOuz4vDMME - 此介面操作簡便,可直接輸入文字並輕鬆調整語音參數。

- SSH 存取(Port 22)

- SSH 提供後端環境的指令列操作權限,適合進階使用者。

- SSH 連線指令:

ssh user@<your-instance> -p 22

- 密碼:可於 Glows.ai 控制台中的實例資訊查看。

步驟 3:儲存與後續應用

- 匯出生成結果

- 透過 WebUI,可以將產生的內容直接儲存至本地設備,方便後續使用。

- 進一步整合應用

- 若需進行大規模文本處理或整合至商業工作流程,可使用 Glows.ai 提供的 API 部署工具,將 Llama 3.1 靈活整合至你的應用或服務中。